红帽 OpenShift AI

什么是红帽 OpenShift AI?

红帽® OpenShift® AI 是一个灵活且可扩展的人工智能(AI)和机器学习(ML)平台,可帮助企业在混合云环境中大规模创建和交付依托 AI 技术的应用。

OpenShift AI 采用开源技术构建,能提供值得信赖且运维一致的功能,助力团队进行实验、供应模型以及交付创新应用。

更快地将依托 AI 技术的应用投入使用

这款一站式企业就绪型 AI 应用平台集结了红帽 Openshift AI 和红帽 OpenShift 成熟可靠的功能,能够让不同团队团结一心、顺畅协作。数据科学家、工程师和应用开发人员可以在统一的平台上进行协作,从而提高一致性、安全性和可扩展性。

OpenShift AI 支持数据的获取和准备、模型的训练和微调、模型供应、模型监控及硬件加速。凭借由硬件和软件合作伙伴组成的开放式生态系统,OpenShift AI 能够满足不同的需求和场景。

借助最新版本的红帽 OpenShift AI,可获享更高的可扩展性、更精准的偏差与漂移检测、更便捷的加速器访问,以及用于共享、部署和跟踪模型的集中式注册表。这将有助于加快企业的 AI/ML 创新速度,并在公共云、数据中心和边缘环境中大规模实现运维一致性。

功能和优势

减少在 AI 基础架构管理上花费的时间

为您的团队提供对资源的按需访问权限,以便他们专注于探索数据并构建为您的组织增加真正价值的应用。获得更多省时省力的好处,例如内置安全防护和 Operator 生命周期集成等。

经过测试、享受支持的 AI/ML 工具

红帽平台可替您跟踪、集成、测试和支持在红帽 OpenShift 应用平台上运行的常见 AI/ML 工具和模型,无需您自己费心费力。OpenShift AI 借鉴了红帽 Open Data Hub 社区项目及 Kubeflow 等开源项目多年的孵化经验。

跨混合云的灵活性

红帽 OpenShift AI 既可以作为自助管理软件使用,也可作为 OpenShift 上的全托管云服务提供,借助这个既安全又灵活的平台,您可以选择在任何位置开发和部署模型,无论是在本地、公共云中还是在边缘。

运用最佳实践

红帽咨询提供各种服务来协助您安装、配置和使用红帽 OpenShift AI,发挥这款产品的最大潜力。

无论您想试用 OpenShift AI Pilot,还是需要 MLOps 基础构建方面的帮助,红帽咨询都能提供支持和指导。

红帽企业 Linux AI

红帽® 企业 Linux® AI 是一个基础模型平台,可无缝开发、测试和运行适用于企业级应用的 Granite 系列大语言模型(LLM)。

通过 IBM watsonx.ai 扩展 AI 的功能

红帽 Openshift AI 为 IBM watson.ai(具有更多生成式 AI 功能)提供了开源基础。

通过 Jupyter notebooks-as-a-service 进行协作

将预构建或自定义的集群镜像提供给数据科学家,方便他们利用 Jupyter notebook 来构建模型。红帽 OpenShift AI 会跟踪对 Jupyter、TensorFlow、PyTorch 及其他开源 AI 技术进行的更改。

借助红帽 OpenShift AI 扩展模型供应

通过它,您可以将供应的模型集成到在本地、公共云中或边缘运行的智能应用中。还可以基于对源 notebook 的更改来重新构建、重新部署和监控这些模型。

解决方案模式

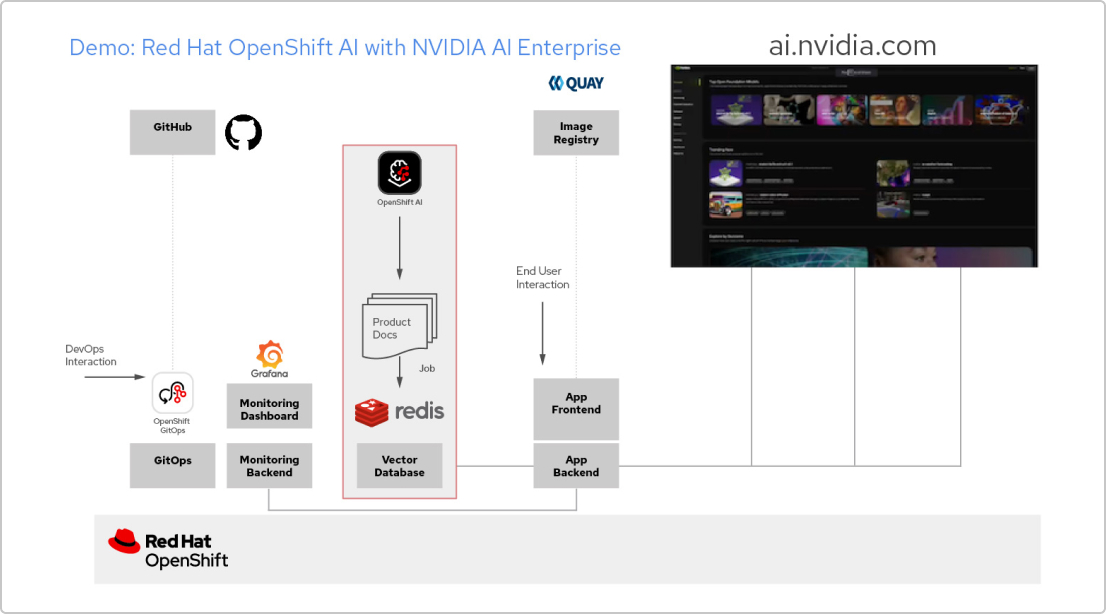

使用红帽技术和 NVIDIA AI Enterprise 构建的 AI 应用

创建 RAG 应用

红帽 OpenShift AI 是一个用于构建数据科学项目并为依托 AI 的应用提供服务的平台。您可以集成支持 检索增强生成(RAG)所需的所有工具,这是一种从自己的参考文档中获取 AI 答案的方法。将 OpenShift AI 与 NVIDIA AI Enterprise 关联后,您可以尝试各种 大语言模型(LLM),以找到适用于您应用的最佳模型。

构建文档处理管道

要使用 RAG,首先需要将文档导入到一个向量数据库中。在示例应用中,我们将一组产品文档嵌入到 Redis 数据库中。由于这些文档经常更改,我们可以为此过程创建一个管道并定期运行,以确保始终拥有最新版本的文档。

浏览 LLM 目录

NVIDIA AI Enterprise 支持访问不同 LLM 的目录,因此您可以尝试不同的选择,并选取能够提供最佳效果的模型。这些模型托管在 NVIDIA API 目录中。设置 API 令牌后,您就可以直接从 OpenShift AI 使用 NVIDIA NIM 模型服务平台来部署模型。

选择合适的模型

在测试不同的 LLM 时,您可以让用户对每个生成的响应进行评分。您还可以设置一个 Grafana 监控面板,用于比较各个模型的评分、延迟和响应时间。然后,您就可以根据这些数据来选择最适合在生产环境中使用的 LLM。

查看相关资源

视频

红帽 OpenShift AI 演示

电子书

为生成式 AI 构建基础的重要注意事项

分析机构资料

Omdia 报告:为 AI 奠定坚实的运维基础

检查清单

在企业组织中成功实施 MLOps 的五大方式

如何试用红帽 OpenShift AI

开发人员沙盒

适合想要尝试在灵活的预配置环境中构建依托 AI 技术的应用的开发人员和数据科学家。

60 天试用

企业组织准备好评估 OpenShift AI 的全部功能后,可以通过 60 天产品试用进行探索。需要用到现有的红帽 OpenShift 集群。