Mit Open Source von KI profitieren

Künstliche Intelligenz (KI) ermöglicht neue Entdeckungen und Erfahrungen in unterschiedlichen Bereichen und Branchen. Nutzen Sie die Open Source-Plattformen von Red Hat, um KI-Modelle und -Anwendungen zu entwickeln, bereitzustellen, zu überwachen und einzusetzen – unterstützt durch die Geschwindigkeit, Vertrauenswürdigkeit und Transparenz der Open Source Community.

Empfohlene Lösungen für die Entwicklung und Nutzung von KI

Red Hat® Enterprise Linux® AI

Erste Schritte mit einem LLM mit Open Source-Lizenz

Red Hat Enterprise Linux AI kann Ihre Kreativität fördern und generative KI-Anwendungen zum Leben erwecken.

Red Hat Enterprise Linux AI vereint die für Open Source lizenzierten großen Sprachmodelle (LLMs) der Granite-Familie und InstructLab, eine communitybasierte Lösung für die Verbesserung von LLM-Funktionen.

Red Hat OpenShift® AI

Erstellen und Ausführen von KI-Anwendungen in der gesamten Hybrid Cloud-Umgebung

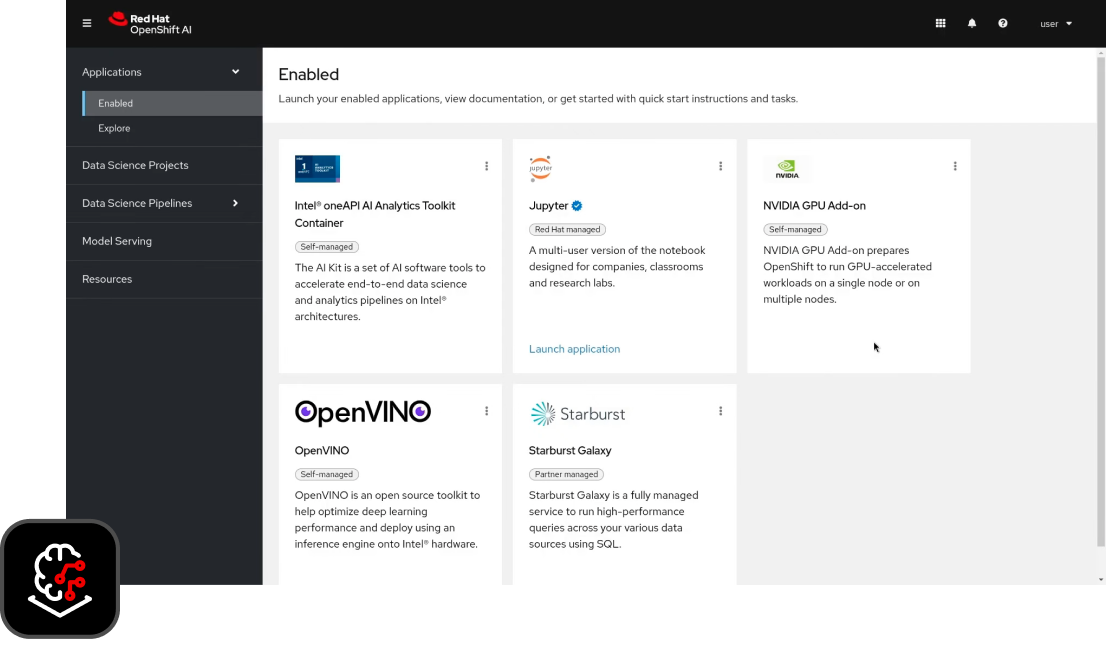

Red Hat OpenShift AI ist eine Open Source-Plattform, auf der Sie Modelle für Ihre eigenen KI-gestützten Anwendungen entwickeln, trainieren, testen und bereitstellen können.

Data Scientists und Entwicklungsteams können ML-Workloads und -Modelle in einer vollständig unterstützten Umgebung On-Premise und in der Public Cloud schnell bereitstellen und überwachen.

Überblick

Red Hat Lightspeed

Einsatz von KI zur Steigerung der Effizienz

Nach Red Hat Ansible® Lightspeed mit IBM watsonx Code Assistant führt Red Hat weitere generative KI-Services ein, mit denen Sie Plattformen einfacher nutzen können.

Zum Portfolio von Red Hat Lightspeed gehört auch OpenShift Lightspeed, ein auf generativer KI basierender virtueller Assistent, mit dem Sie Fehler beheben und Hilfe erhalten können. Darüber hinaus zielt das neue Red Hat Enterprise Linux Lightspeed darauf ab, die Entwicklung, Bereitstellung und Verwaltung von Linux zu vereinfachen.

Warum Red Hat für KI?

Mit der technologischen Basis von Linux, Containern und Automatisierung gibt Ihnen die Open Hybrid Cloud-Strategie von Red Hat die Flexibilität, Ihre KI-Anwendungen dort auszuführen, wo Sie sie benötigen.

Red Hat Enterprise Linux AI ist eine Plattform für Basismodelle, mit der Sie Unternehmensanwendungen mithilfe von großen Sprachmodellen (LLM) der Granite-Familie nahtlos entwickeln, testen und bereitstellen können.

Red Hat OpenShift AI bietet eine gemeinsame Plattform für Ihre Teams, auf der sie KI-Anwendungen und ML-Modelle mit Transparenz und Kontrolle entwickeln und bereitstellen können.

Für umfangreiche KI-Implementierungen bietet Red Hat OpenShift eine skalierbare Anwendungsplattform, die für KI-Workloads geeignet ist und Zugang zu gängigen Hardwarebeschleunigern bietet.

Portfolio von Red Hat Lightspeed

Dank Red Hat Lightspeed können KI-gestützte Tools für mehr Produktivität und eine niedrigere Kompetenzbarriere sorgen – angefangen mit Red Hat Ansible Automation Platform und über das gesamte Red Hat Portfolio hinweg.

Community-Projekte

Red Hat ist davon überzeugt, dass ein Open Source-Ansatz für die KI Hindernisse für Experimente und Innovationen beseitigt.

InstructLab bietet einen neuen Ansatz für Beiträge zu und das Trainieren von LLMs, bei dem die Vorteile des Open Source-Modells für Mitwirkende genutzt werden.

Podman AI Lab bietet Entwicklungsteams die Möglichkeit, generative KI-Anwendungen in einer intuitiven, grafischen Benutzeroberfläche auf ihrer lokalen Workstation zu entwickeln, zu testen und auszuführen.

In der OpenShift AI Sandbox testen

Mit von Open Data Hub und anderen Open Source-Projekten kuratierten Komponenten bietet Red Hat OpenShift AI Data Scientists und Entwicklungsteams eine leistungsstarke, offene, hybride KI/ML-Plattform zum Erfassen von Erkenntnissen aus Daten und zum Erstellen von KI-gestützten Anwendungen. Testen Sie Red Hat OpenShift Data Science in unserer Entwickler-Sandbox.

KI-Partnernetzwerk entdecken

Die KI-Partner von Red Hat tragen zur Vervollständigung Ihrer KI-Pipeline bei. Greifen Sie auf Lösungen zu, die von der Datenintegration und -aufbereitung über die Entwicklung und das Training von KI-Modellen bis hin zur Modellbereitstellung und Inferenz auf der Basis neuer Daten reichen.

Lösungs-Pattern

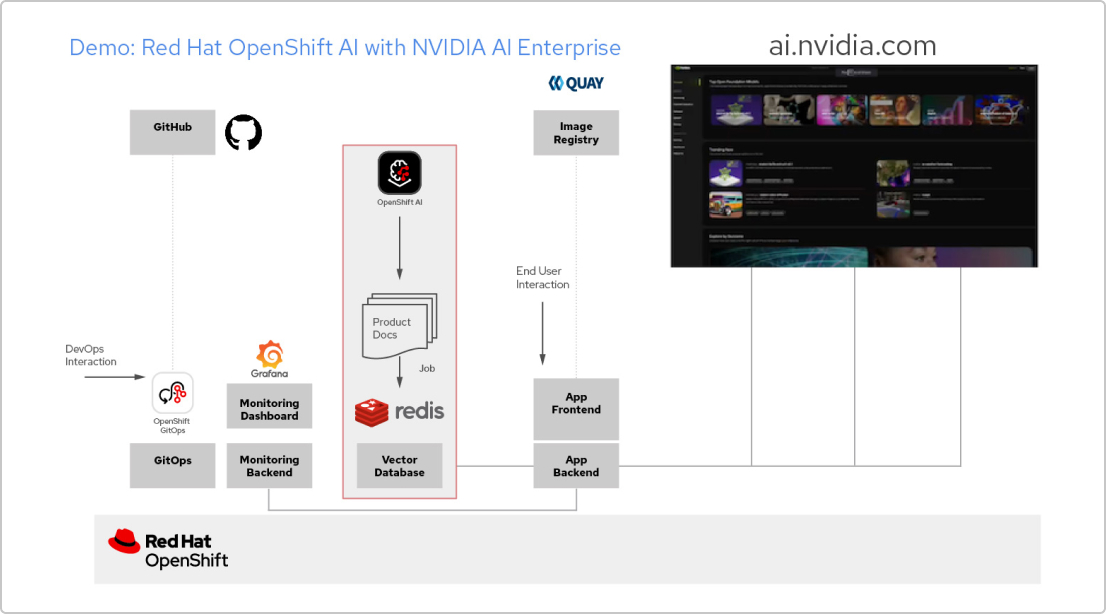

KI-Anwendungen mit Red Hat und NVIDIA AI Enterprise

Entwickeln einer RAG-Anwendung

Red Hat OpenShift AI ist eine Plattform für das Entwickeln von Data Science-Projekten und Bereitstellen von KI-gestützten Anwendungen. Sie können sämtliche für die Unterstützung von Retrieval-Augmented Generation (RAG), einer Methode zum Abrufen von KI-Antworten aus Ihren eigenen Referenzdokumenten, erforderlichen Tools integrieren. Wenn Sie OpenShift AI mit NVIDIA AI Enterprise kombinieren, können Sie mit Large Language Models (LLMs) experimentieren und so das optimale Modell für Ihre Anwendung finden.

Erstellen einer Pipeline für Dokumente

Damit Sie RAG nutzen können, müssen Sie Ihre Dokumente zunächst in eine Vektordatenbank aufnehmen. In unserer Beispielanwendung integrieren wir eine Anzahl von Produktdokumenten in eine Redis-Datenbank. Da sich diese Dokumente häufig ändern, können wir für diesen Prozess eine Pipeline erstellen, die wir regelmäßig ausführen, damit wir immer die aktuellsten Versionen der Dokumente zur Verfügung haben

Durchsuchen des LLM-Katalogs

Mit NVIDIA AI Enterprise können Sie auf einen Katalog verschiedener LLMs zugreifen. So können Sie verschiedene Möglichkeiten ausprobieren und das Modell auswählen, das die optimalen Ergebnisse erzielt. Die Modelle werden im NVIDIA API-Katalog gehostet. Sobald Sie ein API-Token eingerichtet haben, können Sie ein Modell mit der NVIDIA NIM Model Serving-Plattform direkt über OpenShift AI bereitstellen.

Auswählen des richtigen Modells

Beim Testen verschiedener LLMs können Ihre Nutzerinnen und Nutzer die einzelnen generierten Antworten bewerten. Sie können ein Grafana Monitoring Dashboard einrichten, um die Bewertungen sowie die Latenz- und Antwortzeiten der einzelnen Modelle zu vergleichen. Anhand dieser Daten können Sie dann das optimale LLM für den Produktionseinsatz auswählen.

KI-Success Stories aus der Praxis

Red Hat Helps Ortec Finance Accelerate Growth and Time to Market

Ortec Finance, ein globaler Anbieter von Technologien und Lösungen für das Risiko- und Renditemanagement, stellt ML-Modelle auf Microsoft Azure Red Hat OpenShift bereit und führt Red Hat OpenShift AI ein.

Banco Galicia beschleunigt das Onboarding von Neukunden

Die Bank nutzt eine KI-basierte Lösung für Natural Language Processing (NLP), die auf Red Hat OpenShift beruht. Damit konnte Banco Galicia die Überprüfungszeiten von Tagen auf Minuten verkürzen und eine Genauigkeit von 90 % erzielen.

Boston University entwickelt eine Bildungsplattform

Mithilfe von Red Hat OpenShift AI konnte die Boston University eine Lernumgebung skalieren, die Hunderte von Nutzenden aus den Bereichen Informatik und Computertechnik aufnehmen kann.