検索や分類などの用途のためにベクトル化を行うモデル「BERT」の後継モデル「ModernBERT」が登場

AI研究機関のAnswer.AIとLightOnが、2018年に発表されたGoogleの自然言語処理モデル「BERT」を改善した「ModernBERT」を開発しました。検索、自然言語理解、コード検索などのタスクにおいて、優れた性能を示すとのことです。

Finally, a Replacement for BERT: Introducing ModernBERT – Answer.AI

https://www.answer.ai/posts/2024-12-19-modernbert.html

BERTは、文章中の単語を推測するときに単語の前だけでなく後ろの文脈にも基づいた推測を可能にするという、発表当時は目新しかった仕組みを提供したAIモデルです。この特徴と、ラベル付けが施されていない生のデータを学習できるという点、学習済みのモデルをほかのタスクに活用できる「転移学習」が実行できる点などが評価されて多数の研究に応用され、このモデルによりAIの技術が飛躍的に向上したともいわれています。2024年時点でも、HuggingFaceで2番目にダウンロード数が多いモデルだとのことです。

Answer.AIとLightOnの研究者は、近年の大規模言語モデルの研究から多くの要素を取り入れ、アーキテクチャや学習プロセスをアップデートした「ModernBERT」を公開しました。

ModernBERT - a answerdotai Collection

https://huggingface.co/collections/answerdotai/modernbert-67627ad707a4acbf33c41deb

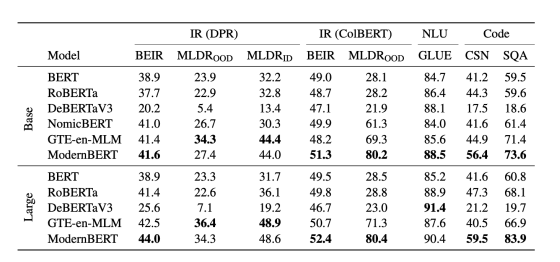

ModernBERTは、BERTより高速で高精度であることに加え、コンテキストの長さを8k(8192)トークンまで増加させたというモデルです。これにより、検索、自然言語理解、コード検索という3つのタスクカテゴリのほぼすべてにおいて他モデルよりも優れた性能を示したとのことです。

ModernBERTは、BERTと同じくエンコーダ専用モデルです。エンコーダ専用モデルは「数値のリスト(埋め込みベクトル)」を出力するという特徴があり、人間にわかるようなテキストを文字通り数値にエンコードしていると言えます。エンコードしたデータをデコーダ専用モデルに渡すことで、デコード専用モデルは文章や絵を生成できます。

デコーダ専用モデルはエンコーダ専用モデルと同様の動作をすることができますが、数学的には次に入力されるトークンをのぞき見ることは許されていないという制約に阻まれています。デコーダ専用モデルは過去のトークンを見るように訓練されており、この仕組みで効率的な処理を行っています。

研究者らによると、デコーダ専用モデルは多くのタスクにとって規模が大きすぎ、遅すぎ、高価すぎという欠点があり、一般のユーザーにとって不便と感じられることがあるそうです。研究者らはデコーダ専用モデルをフェラーリ・SF-23に、エンコーダ専用モデルをホンダのシビックにたとえ、「前者はレースに勝つかもしれないがメンテナンスコストが高く、後者は手頃で燃費も良い」と表現。エンコーダ専用モデルの性能を伸ばすことで、より安価かつ高性能なモデルを選択肢として用意することを目指したと述べました。

実際、BERTをベースとして作られたモデルの1つ「RoBERTa」のダウンロード数は多くのデコーダ専用モデルよりHuggingFace上のダウンロード数が多く、需要は非常に高いとのことです。

ModernBERTは、検索(DPR/ColBERT)、自然言語処理(NLU)、コード検索(Code)の性能を測定する複数のベンチマークにおいて、他のモデルを上回っています。また、他のエンコーダ専用モデルより16倍以上長い8kトークンの入力が可能な点でもアドバンテージがあります。

Answer.AIとLightOnの研究者は、「コミュニティがどんな方法でModernBERTを使うのか、楽しみにしています」と述べました。

・関連記事

ChatGPTなどの大規模言語モデルはどんな理論で成立したのか?重要論文24個まとめ - GIGAZINE

Metaが言語・画像・音声など複数分野に適応できる自己学習型AI「data2vec」を発表 - GIGAZINE

Googleの自然言語処理モデル「BERT」はインターネット上から偏見を吸収してしまうという指摘 - GIGAZINE

機械学習モデルの再学習でLoRAよりもより少ない計算コストと時間でより高いパフォーマンスを期待できる「DoRA」 - GIGAZINE

・関連コンテンツ